Elimination du bruit après 2 applications du filtre médian

Elimination du bruit après 2 applications du filtre médian

Une première étape lors de la reconstruction d'une image consiste à corriger les défauts introduits par les pixels défectueux. En effet, lors de la fabrication d’un capteur ou pendant sa durée de vie, certains pixels perdent leur sensibilité à la lumière (pixels morts) et créent des points noirs dans l’image. D’autres pixels deviennent ≪ hypers-sensibles ≫ à la lumière et créent des points très lumineux. Ce défaut est assimilé à un bruit impulsionnel et peut être efficacement corrigé par l’application d’un filtre médian.

Elimination du bruit après 2 applications du filtre médian

Elimination du bruit après 2 applications du filtre médian

D’autre part, l’image de mosaïque des couleurs primaires, rouge, vert et bleu, doit être interpolée pour produire une image en couleur. Il s’agit dans cette étape de reconstruire les deux composantes de couleur manquantes pour chaque pixel. De nombreux algorithmes de dématriçage existent produisant différentes qualités d’images.

Image capturée par l'appareil photo.

Image capturée par l'appareil photo.

L'image vue par un capteur n'est pas complète. Comparons l'image réelle (à gauche) à celle enregistrée par le capteur (à droite) :

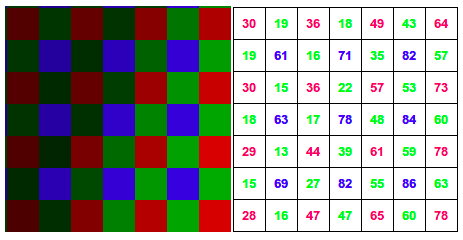

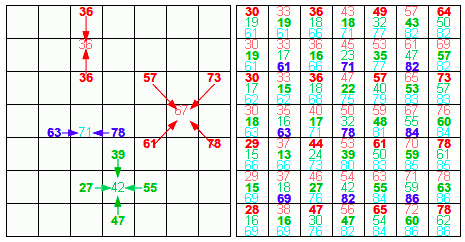

Pour chaque pixel, un seul "canal" (rouge, vert ou bleu) est enregistré. Si l'on zoome sur une partie de l'image (en bas), on constate que la matrice de Bayer est bien visible dans le blanc, et plus ou moins remplacée par des "trous" dans les zones saturées de l'image : dans une zone rouge, par exemple, les pixels sensibles au rouge sont clairs, mais ceux sensibles au bleu ou au vert sont noirs.

Le capteur envoie donc un tableau de nombres, chacun correspondant à un seul canal (dans notre exemple, tableau en pourcentages correspondant à un extrait du centre de l'éventail). C'est ce tableau de données brutes qui est stocké dans un fichier "Raw" sur les appareils proposant cette fonction.

Or, une image informatique comporte bien trois valeurs par pixel : rouge, vert et bleu, et c'est le mélange de ces trois valeurs qui lui donne sa couleur. Il nous faut donc trois nombres pour chaque pixel. C'est l'opération baptisée "dématriçage" : on regarde autour pour attribuer les valeurs manquantes.

Nous avons vu sur la page précédente une méthode d'interpolation : on reconstruit un pixel - et ses trois composantes - à partir des 4 photosites que ce pixel recouvre.

On pourrait tout aussi bien proposer une autre méthode : chaque photosite, accompagné de ses 8 photosites « voisins » permet le calcul de trois composantes rouge, verte et bleu. Contrairement à la méthode vue dans l'exemple précédent, l'interpolation prend en compte non pas 4 photosites, mais 9 photosites.

Ainsi, on peut faire la moyenne des valeurs de la couleur qu'on cherche dans les photosites adjacents (à gauche), sur deux ou quatre pixels selon le cas. On obtient alors un tableau (à droite, les valeurs enregistrées en gras, les valeurs calculées en maigre) avec, pour chaque pixel, les trois couleurs : autrement dit, une image "bitmap" que l'on pourra par exemple enregistrer en Jpeg. Du point de vue de l'ordinateur, c'est ce tableau-ci que l'on affichera à l'écran.

C'est lors de cette étape que peuvent apparaître certaines interférences déplaisantes, la plus connue étant le moirage.

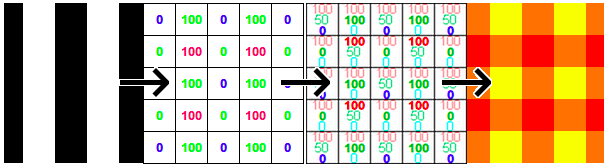

Prenons un cas extrême, parfait comme il n'en existe qu'en théorie :

Nous photographions des lignes verticales noires et blanches qui, coup de chance, sont projetées sur le capteur avec exactement la même alternance que les photosites de celui-ci (on parle de "fréquence spatiale"). Voyez : les photosites sensibles au bleu sont tous sur des lignes noires, et renvoient 0. Ceux sensibles au rouge sont sur des lignes blanches, et renvoient 100 ; enfin, les verts alternent entre les deux extrêmes.

Le dématriçage, en propageant les valeurs aux pixels adjacents, produit des interférences colorimétriques : l'image paraît quadrillée rouge / jaune au lieu d'être striée blanc / noir.

Ce phénomène se produit lorsque des petits détails arrivent près de la fréquence spatiale du capteur. C'est souvent le cas sur les rambardes de balcons ou les tuiles lorsqu'on photographie des maisons lointaines, mais également avec des cheveux, du feuillage ou d'autres motifs.

Pour réduire ces interférences, on trouve deux solutions.